2023亚太OTT/IPTV大会暨新视听Connected TV大会于4月19-20日在北京王府井金茂万丽酒店隆重召开,是数智中国科技周重要活动之一。大会上重磅启动AIGC协同体 • 新媒体元宇宙产业联盟,并解读《全球元宇宙创新示范案例100强案例集》。

在4月19日上午举办的2023亚太OTT/IPTV大会暨新视听Connected TV大会上,原广电总局副总工、国家信息化专家咨询委员会专家、国务院三网融合专家组专家 杜百川老师发表题为《AIGC和监管》的主题演讲。

原广电总局副总工、国家信息化专家咨询委员会专家 国务院三网融合专家组专家 杜百川

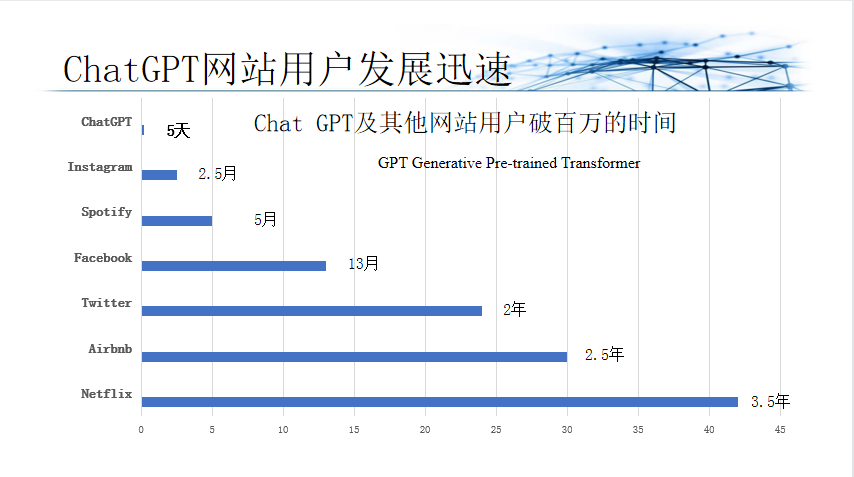

在美国关键与新兴技术的清单上将先进计算列为第一条,也将人工智能的生成内容归为萌芽期,但实际上ChatGPT发展非常快(英文),Netflix用了3.5年达到了用户100万,而LVMV用了2.5年,Twitter用了2年,FaceBook用了3个月,SWOT用了5个月,Instagram用了2.5个月,而ChatGPT只用了5天。人工智能生成实际上是从PGC到AIGC,也就是说从专业生成的内容,到用户生成的内容,到AI辅助生成的内容,到AI自己生成的内容,包括数字内容、包括文字、图片、视频、代码设计、电路设计、建筑设计、消费品、药物设计等,可以说是一种通用AI。

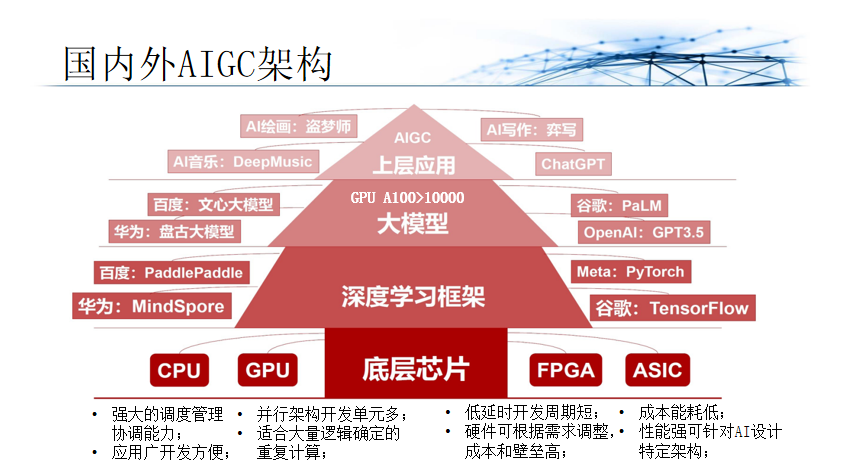

近年来,LLM模型规模在快速增长,其参数规模大都超过了千亿(100B)参数规模。如OpenAI的GPT 3的为175B,Google的LaMDA为137B,PaLM为540B,DeepMind的Gogher为280B等。国内中文巨型模型,如智源GLM规模130B,华为“盘古”规模200B,百度“文心”规模260B,浪潮“源1.0”规模245B。

ChatGPT4和GPT3一样,可以预测文档当中的下一个文字,并且提高了安全性和真实性,既有多语言的能力和图像的能力,现在图像没有开放。核心部分是开发了优化方法和基础设施,可以用小于千分之一的模型来准确预测性能的模型,英语的多项选择题,实现了24种语言,超过英语的最先进水平。

GPT-4:OpenAI还没有透露GPT-4硬件架构、训练计算、数据集架构、如何训练的细节,只知道GPT-4是transformer-类,用公共和许可的第三方数据RLHF微调的生成多模式训练。但OpenAI确实共享了有关升级的RLHF技术的细节以便模型有更精准的响应来越过外部安全护栏。在训练策略模型(与 ChatGPT相同)后,RLHF 用于对抗性训练,对恶意示例训练模型,以便在未来保护模型。就 GPT-4 而言,多个领域的人类专家对政策模型对对抗性提示进行了评级。然后这些响应将用于训练额外的奖励模型,迭代微调策略模型,生成不太可能给出危险、回避或不准确响应的模型。

AIGC的发展也引起一部分人的担忧,如GPT-4会得出错误结论,散布虚假消息,控制人类电脑,泄露企业数据,雇人打工,引诱别人,潜入家庭,欺骗人类诱使通过验证码(CAPTCHA)测试,准备逃跑,“接管世界”,几万人签名要求暂停训练6个月。欧洲刑警组织创新实验室也发布报告,揭示了通过ChatGPT可能的诸多犯罪行为。

AI治理已经出台了一系列规则,如:2019.3 IEEE《旨在推进人工智能和自治系统的伦理设计的IEEE全球倡议书》,2019.3 G20 《G20人工智能原则》,2019.4欧盟《人工智能道德保障》,2019. 8中国《人工智能行业自律公约》,2019.9中国《新一代人工智伦理业规范》2021年联合国科教文组织《人工智能伦理问题建议书》,美国2021.11《人工智能指南 道德准则》。

2023年中国国家网信办起草了《生成式人工智能服务管理办法(征求意见稿)》,它的处罚依据是三个安全法,比如说中华人民共和国网络安全法、数据安全法、信息保护安全法,是非常全面。在同一天美国NTIA商务部的国家电信和信息管理局也发起意见征求,主要是以下议题,人工智能开发公司企业客户应当进行什么样的信任和安全设施。第二进行审计和评估需要什么样的数据访问。第三监管机构和其它参与者应当如何鼓励和支持人工智能系统的可信保证,以及其他形式的问责制。第四不同行业可能需要哪些不同的方法,如就业医疗保健等等。

2023年2月,中国电子技术标准化研究院等54单位编写《人工智能伦理治理标准指南》,主要围绕2022.3.20中国办《关于加强科技伦理治理的意见》、2021.9.26科技部国家新一代人工智能治理委员会《新一代人工智能伦理规范》和2023.1外交部《中国关于加强人工智能伦理治理的立场文件》。重点围绕四个方面:人工智能伦理概念和范畴;人工智能伦理风险评估;人工智能伦理治理技术;人工智能伦理治理标准化。

“深度造假”这个术语于 2017 年首次出现,用于描述由人工智能 (AI) 技术生成的逼真的照片、音频、视频和其他伪造品-可能在未来几年给国家安全带来各种挑战。随着这些技术的不断成熟,它们可能对国会监督、美国国防授权和拨款以及社交媒体平台的监管产生重大影响。

如今,无需专门的检测工具即可检测到深度伪造。然而,该技术的复杂性正在迅速发展到无人辅助检测将非常困难或不可能的地步。在NSF和NIST的指导下确认生成对抗网络输出法令(P.L. 116-258)以支持GAN的研究。特别是NSF指导支持内容和消息的授权研究变换或合成,而NIST指导支持开发测量和标准所需工具的研究,以核查GANs的输出功能或变换或合成内容的其它技术。

DARPA 有两个程序专门用于检测深度伪造:媒体取证 (MediFor) 和语义取证 (SemaFor)。MediFor 于 2021 财年结束,将开发算法以自动评估照片和视频的完整性,并向分析师提供有关假冒内容如何生成的信息。据报道,该计划探索了识别深度伪造中存在的视听不一致的技术,包括像素不一致(数字完整性)、物理定律不一致(物理完整性)以及与其他信息源的不一致(语义完整性)。MediFor 技术有望过渡到作战指挥部和情报界。

下一篇:智屏新趋势 | 易平方、秒针系统、蓝色光标、元隆宇宙与贾振丹热议智屏运营及AIGC+元宇宙广告上一篇:解锐:Mixed AI赋能智能制造 | 2023亚太OTT/IPTV大会暨新视听Connected TV大会

责任编辑:王旭